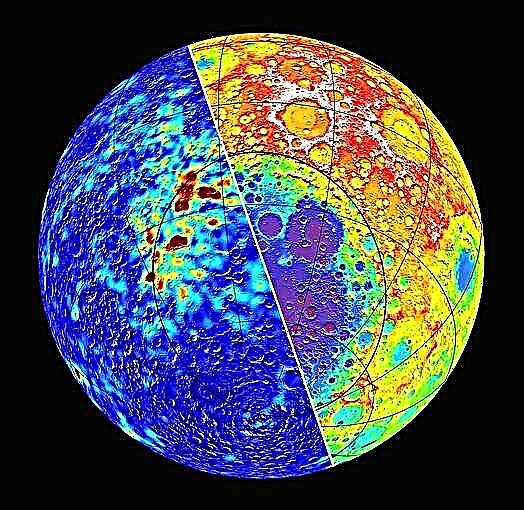

Sinds het begin van de 20e eeuw worden wetenschappers en natuurkundigen belast met het uitleggen hoe en waarom het heelal in versneld tempo lijkt uit te breiden. Behalve dat het verantwoordelijk is voor kosmische versnelling, wordt aangenomen dat deze energie ook 68,3% van de niet-zichtbare massa van het universum omvat.

Net zoals donkere materie, is het bestaan van deze onzichtbare kracht gebaseerd op waarneembare verschijnselen en omdat het toevallig past bij onze huidige modellen van kosmologie, en niet bij direct bewijs. In plaats daarvan moeten wetenschappers vertrouwen op indirecte waarnemingen en kijken hoe snel kosmische objecten (met name Type Ia supernovae) van ons afnemen naarmate het universum zich uitbreidt.

Dit proces zou uiterst vervelend zijn voor wetenschappers - zoals degenen die voor de Dark Energy Survey (DES) werken - ware het niet dat de nieuwe algoritmen die door onderzoekers van het Lawrence Berkeley National Laboratory en UC Berkeley gezamenlijk zijn ontwikkeld, zijn ontwikkeld.

"Ons algoritme kan een detectie van een supernova-kandidaat in ongeveer 0,01 seconden classificeren, terwijl een ervaren menselijke scanner enkele seconden kan duren", zegt Danny Goldstein, een afgestudeerde student van UC Berkeley die de code heeft ontwikkeld om het proces van supernova-ontdekking op DES-afbeeldingen te automatiseren. .

Momenteel, in het tweede seizoen, maakt de DES nachtelijke foto's van de Southern Sky met DECam - een 570-megapixelcamera die is gemonteerd op de Victor M. Blanco-telescoop bij Cerro Tololo Interamerican Observatory (CTIO) in de Chileense Andes. Elke nacht genereert de camera tussen 100 Gigabytes (GB) en 1 Terabyte (TB) beeldgegevens, die naar het National Center for Supercomputing Applications (NCSA) en DOE's Fermilab in Illinois worden gestuurd voor de eerste verwerking en archivering.

Objectherkenningsprogramma's die zijn ontwikkeld bij het National Energy Research Scientific Computing Center (NERSC) en geïmplementeerd bij NCSA, kammen vervolgens door de beelden op zoek naar mogelijke detecties van Type Ia supernovae. Deze krachtige explosies vinden plaats in dubbelstersystemen waarbij één ster een witte dwerg is, die materiaal van een begeleidende ster ophoopt tot het een kritische massa bereikt en explodeert in een Type Ia-supernova.

"Deze explosies zijn opmerkelijk omdat ze kunnen worden gebruikt als kosmische afstandsindicatoren met een nauwkeurigheid van 3-10 procent", zegt Goldstein.

Afstand is belangrijk omdat hoe verder weg een object zich in de ruimte bevindt, hoe verder terug in de tijd het is. Door Type Ia supernovae op verschillende afstanden te volgen, kunnen onderzoekers de kosmische expansie door de geschiedenis van het universum meten. Hierdoor kunnen ze beperkingen opleggen aan hoe snel het universum zich uitbreidt en misschien zelfs andere aanwijzingen geven over de aard van donkere energie.

"Wetenschappelijk gezien is het een heel spannende tijd omdat verschillende groepen over de hele wereld Type Ia supernovae nauwkeurig proberen te meten om de donkere energie die de versnelde uitdijing van het universum aandrijft, te beperken en te begrijpen", zegt Goldstein, die ook student is onderzoeker in het Computational Cosmology Center (C3) van Berkeley Lab.

De DES begint zijn zoektocht naar explosies van type Ia door veranderingen in de nachtelijke hemel aan het licht te brengen, waar de beeldaftrekpijplijn wordt ontwikkeld en geïmplementeerd door onderzoekers in de DES supernova-werkgroep. De pijplijn trekt beelden die bekende kosmische objecten bevatten af van nieuwe afbeeldingen. die elke nacht worden tentoongesteld bij CTIO.

Elke nacht produceert de pijpleiding tussen de 10.000 en een paar honderdduizend detecties van supernovakandidaten die moeten worden gevalideerd.

“Historisch gezien zaten getrainde astronomen uren achter de computer, keken naar deze punten en gaven hun mening over de vraag of ze de kenmerken van een supernova hadden, of dat ze werden veroorzaakt door valse effecten die zich voordoen als supernovae in de gegevens. Dit proces lijkt eenvoudig totdat je je realiseert dat het aantal kandidaten dat elke nacht moet worden geclassificeerd onbetaalbaar groot is en dat slechts één op de honderden het een echte supernova van welk type dan ook is, ”zegt Goldstein. “Dit proces is extreem vervelend en tijdrovend. Het zet ook de supernova-werkgroep onder grote druk om snel gegevens te verwerken en te scannen, wat hard werken is. ”

Om de taak van het doorlichten van kandidaten te vereenvoudigen, ontwikkelde Goldstein een code die de machine-leertechniek "Random Forest" gebruikt om detecties van supernovakandidaten automatisch en in realtime te onderzoeken om ze te optimaliseren voor de DES. De techniek maakt gebruik van een geheel van beslissingsbomen om automatisch de soorten vragen te stellen die astronomen doorgaans zouden overwegen bij het classificeren van supernovakandidaten.

Aan het einde van het proces krijgt elke detectie van een kandidaat een score op basis van de fractie van beslissingsbomen die van mening waren dat deze de kenmerken had van een detectie van een supernova. Hoe dichter de classificatiescore bij één ligt, hoe sterker de kandidaat. Goldstein merkt op dat in voorlopige tests de classificatiepijplijn een algehele nauwkeurigheid van 96 procent behaalde.

"Als je alleen aftrekt, krijg je veel te veel‘ false-positives ’- instrumentele of softwarematige artefacten die zich voordoen als potentiële supernovakandidaten - voor mensen om door te spitten,» zegt Rollin Thomas, van Berkeley Lab's C3, die Goldstein's medewerker was.

Hij merkt op dat onderzoekers met de classificator de artefacten van supernovakandidaten snel en nauwkeurig kunnen verwijderen. "Dit betekent dat in plaats van dat twintig wetenschappers van de supernova-werkgroep elke avond duizenden kandidaten doorzoeken, je maar één persoon kunt aanstellen om misschien naar een paar honderd sterke kandidaten te kijken", zegt Thomas. "Dit versnelt onze workflow aanzienlijk en stelt ons in staat supernova's in realtime te identificeren, wat cruciaal is voor het uitvoeren van vervolgwaarnemingen."

"Met ongeveer 60 cores op een supercomputer kunnen we 200.000 detecties in ongeveer 20 minuten classificeren, inclusief tijd voor database-interactie en extractie van functies." zegt Goldstein.

Goldstein en Thomas merken op dat de volgende stap in dit werk is om een tweede niveau van machine learning aan de pijplijn toe te voegen om de classificatienauwkeurigheid te verbeteren. Deze extra laag houdt rekening met hoe het object in eerdere waarnemingen is geclassificeerd, aangezien het de waarschijnlijkheid bepaalt dat de kandidaat 'echt' is. De onderzoekers en hun collega's werken momenteel aan verschillende benaderingen om dit vermogen te bereiken.